تفشل أنظمة الذكاء الاصطناعي في التعرف على النساء ذوات البشرة الملونة، فتصنفهن بنحو غير صحيح على أنهن ذكور.

أصبحت مخاطر التحيز والأخطاء في خوارزميات الذكاء الاصطناعي معروفة الآن، ومع ذلك ارتكبت شركات التكنولوجيا أخطاءً فادحة في الأشهر الأخيرة.

وأنتجت الإصدارات الأولية من (ChatGPT) مخرجات عنصرية خاصة ضد النساء السوداوات، وكشفت مولدات صور (DALL-E 2) و(Stable Diffusion) عن تحيز عرقي في الصور التي أنشأتها.

خطأ يتكرر عبر السنين

أوضح أستاذ علوم الكمبيوتر في كلية ديكنسون الأمريكية، جون ماكورميك، أن باحثة الذكاء الاصطناعي، جوي بولامويني، ألقت قصيدة عام 2019 بعنوان “ألست امرأة أيها الذكاء الاصطناعي؟” انتقدت فيها التحيز العنصري في أنظمة التعرف التلقائي على الوجوه، التي طورتها شركات التكنولوجيا مثل جوجل ومايكروسوفت.

وأضاف أن القصدة ذكرته بأنه أنشأ ذات مرة خوارزمية متحيزة عنصريًّا، في عام 1998، تتتبع حركات رأس الشخص بناءً على مدخلات من كاميرا فيديو، وأنه طور تقنيات رياضية يمكنها استخراج المناطق ذات لون الجلد من الصورة في الوقت الفعلي.

وقال إنه ارتكب خطأً غير مقصود، حين أنشأ خوارزمية ذكاء اصطناعي متحيزة عنصريًّا، فوضع خوارزميات البرنامج مخصصة لذوي البشرة الفاتحة متجاهلًا ذوي البشرة الملونة، ما جعل أنظمة الذكاء الاصطناعي تعطي نتائج سيئة بسبب العرق والجنس، لافتًا إلى أن هذا الخطأ لا يزال يتكرر مع الشركات الكبرى.

الامتياز والأولويات

قال ماكورميك، في تقرير نشره موقع كونفرزيشن، الثلاثاء 9 مايو 2023، إن أحد الحلول المقترحة لهذا التمييز العنصري التعامل مع جميع ألوان البشرة على قدم المساواة، وعلى مبرمجي الذكاء الاصطناعي التأكد من أن بيانات النظام تمثل نطاق جميع ألوان البشرة على قدم المساواة قدر الإمكان.

وأضاف أن هذا الحل، لسوء الحظ، لا يضمن أن النظام سيتعامل مع جميع ألوان البشرة على قدم المساواة، لأن النظام يجب أن يصنف كل لون محتمل على أنه جلد أو غير جلد، فعلى الحدود بين الجلد وغير الجلد توجد ألوان مباشرة، ما يجعل تصنيف الشخص الذي يتخطى لون بشرته هذه الحدود بنحو غير صحيح.

يصنف الشخص الذي يتخطى لون بشرته هذه الحدود بشكل غير صحيح

وأوضح أن العلماء يواجهون معضلة سيئة عند دمج التنوع في نماذج التعلم الآلي، فالنماذج المتنوعة والشاملة تعطي أداءً أسوأ من النماذج الضيقة، فالخوارزمية التي تتعقب الجلد الأبيض فقط ستكون أكثر دقة من الخوارزمية التي تتعقب النطاق الكامل لألوان بشرة الإنسان، ما يؤثر لا شعوريًّا في العلماء في دقة الخوارزميات.

مخبأة في الأرقام

أوضح الكاتب أن مشكلة التحيز الخفي تكون أكثر حدة في أنظمة التعلم الآلي الحديثة، فغالبًا ما تحتوي الشبكات العصبية العميقة، وهي النوع الأكثر شيوعًا وقوة من نماذج الذكاء الاصطناعي حاليًّا، على ملايين الأرقام التي يمكن فيها ترميز التحيز، لافتًا إلى أن جميع أنظمة الذكاء الاصطناعي المتحيزة في التعرف على الوجوه شبكات عصبية عميقة.

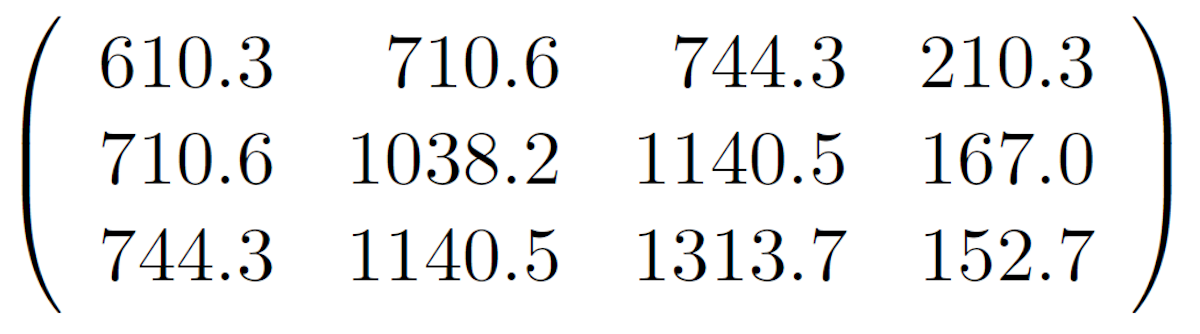

تقع هذه المصفوفة في قلب نموذج لون البشرة

وذكر أن بعض النماذج أحرزت قدرًا كبيرًا من التقدم في عدالة الذكاء الاصطناعي، سواء في الأوساط الأكاديمية أو في الصناعة، لافتًا إلى مجموعة بحثية تُعرف باسم (FATE) كرستها شركة مايكروسوفت للعدالة والمساءلة والشفافية والأخلاق في الذكاء الاصطناعي.

المنافسة التجارية

قال الكاتب “عدم التحيز يمكن أن يكون ضحية للضغوط التنافسية في الأوساط الأكاديمية والصناعية”، لافتًا إلى أن روبوتي الدردشة “بارد” و”بينج” اللذين أصدرتهما جوجل ومايكروسوفت، هما دليل حديث على هذه الحقيقة المروعة، فقد أدت المنافسة التجارية إلى إطلاقها رغم ما بها من عيوب.

وأوضح أن الأنظمة الحديثة تعاني نفس المشكلات مثل جهاز تعقب الرأس الذي صممه عام 1998، فما زالت بيانات التدريب متحيزة، كما أنها تواجه عملية استحالة رياضية للتعامل مع جميع الفئات على قدم المساواة. رغم أن تحيزاتها تتوارى خلف ملايين من الخوارزميات العددية الغامضة.

وأضاف أنه من الواضح أن إنشاء أنظمة ذكاء اصطناعي متحيزة لا يزال مستمرًّا وعن غير قصد، موضحًا أن التحيز في هذه الأنظمة يمكن أن يكون ضارًّا ويصعب اكتشافه، بل يصعب القضاء عليه، معربًا عن أسفه من أن العديد من الخوارزميات لن تحقق العدالة والانصاف العرقي والجنسي حتى في وقت قريب.

اقرأ أيضًا: الذكاء الاصطناعي.. حقل ألغام أخلاقي

اقرأ أيضًا: توقعات متفائلة لسوق الذكاء الاصطناعي الصينية بحلول 2026

رابط مختصر : https://roayahnews.com/?p=1508444